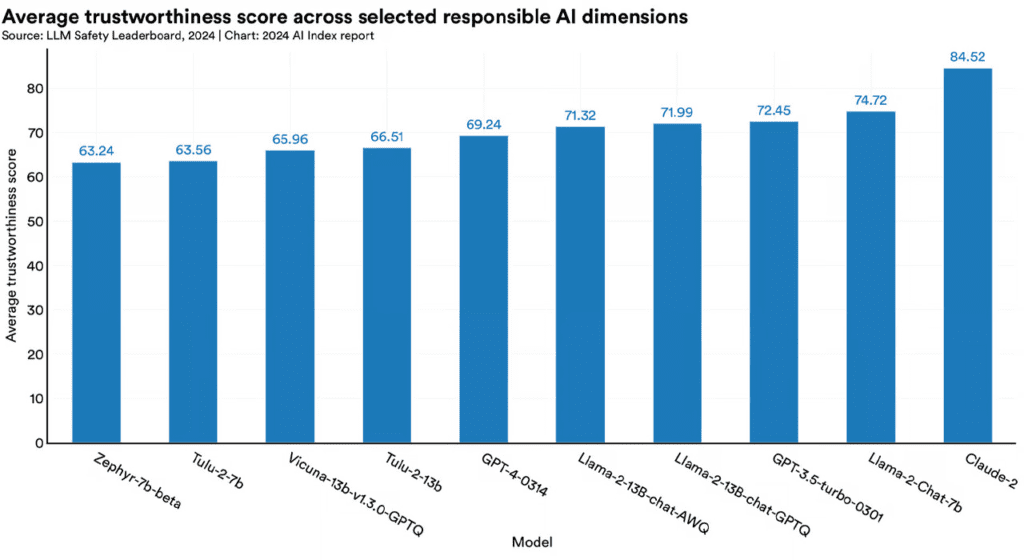

Stanford Üniversitesi‘nin yeni yayımlanan ‘AI Index 2024‘ raporu yapay zeka dil modellerinin güvenilirliğini mercek altına alıyor. Bu derinlemesine incelemede yapay zeka dil modelleri adil davranış, önyargısızlık, gizlilik koruması, güvenlik ve etik gibi kritik alanlarda DecodingTrust ilkeleri temelinde değerlendirildi.

En Güvenilir Yapay Zeka Dil Modelleri

Araştırmanın sonuçlarına göre en yüksek puanı 84.52 ile Anthropic’in Claude-2 modeli alırken, Meta’nın Llama-2-Chat-7b modeli 74.72 puanla hemen arkasından geliyor. Buna karşın OpenAI’nin GPT-4 modeli 69.24 puanla beklentilerin altında kalarak sıralamada geriledi. Bu bulgular yapay zeka dil modellerinin güvenilirliğinin sadece teknolojik gelişmelerle değil, aynı zamanda etik standartlara olan bağlılıklarıyla da ölçüldüğünü gösteriyor.

Yapay Zeka ve Etik Endişeler

Rapor özellikle GPT tipi modellerin önyargılı çıktılar üretme eğilimi ve özel bilgileri sızdırma potansiyeline dikkat çekiyor. Bu durum yapay zeka geliştiricileri için ciddi endişeler doğurmakta ve onları uyarıyor. Stanford Üniversitesi’nin bu çalışması yapay zeka dil modellerinin güvenilirliğini artırmak için atılması gereken adımları vurgulayarak, yapay zeka gelişmelerinin etik ve güvenilir uygulamalarla uyumlu olmasını sağlamada kritik bir rol oynuyor.